Gli Universi nei computer

Viaggio (virtuale) nel mondo delle simulazioni cosmologiche.

Franco Vazza – Osservatorio Astronomico di Amburgo

Non esiste praticamente branca della moderna scienza nel quale le simulazioni numeriche non rivestano un ruolo importante o addirittura preponderante. Dalla chimica alla biologia, dall’ingegneria agli studi economici: dovunque c’è la necessità di studiare l’evoluzione di sistemi complessi regolati da molte variabili, l’utilizzo di modelli matematici al computer è fondamentale perché una qualsiasi teoria arrivi a formulare previsioni quantitative.

Piloti ed astronauti ogni giorno vengono addestrati con sofisticati simulatori di volo; architetti ed ingegneri progettano opere mastodontiche via software, molto prima che un singolo mattone venga posato al suolo; analisti economici stimano i diversi scenari globali a lungo termine innescati da una crisi finanziaria; chimici sintetizzano nuove molecole industriali senza mettere le mani alle provette; meteorologi seguono il succedersi virtuale di fronti caldi e fronti freddi in un computer, ed azzardano il tempo che farà tra una settimana…e così via.

Nella maggior parte delle scienze fisiche, il ricorso alle simulazioni è solitamente uno straordinario optional, mentre nel caso dell’astrofisica è un passo assolutamente necessario. Un chimico teoricamente potrebbe (avendo tempo e denaro) sperimentare tutte le migliaia di permutazioni tra molecole fino a sintetizzare quello che cerca: tuttavia può essere un processo molto lungo e costoso.

Nel caso di un astrofisico intento a studiare la nascita delle galassie, questo problema non si pone proprio: gli oggetti del suo studio sono talmente distanti nello spazio, e lenti ad evolvere nel tempo, che niente di lontanamente paragonabile ad un “esperimento” è pensabile

Dalla seconda metà del secolo scorso in poi, ha preso sempre più piede la consapevolezza che i codici numerici (ovvero lunghe sequenza di operazioni aritmetiche) possano rappresentare la migliore approssimazione possibile ad un “esperimento” in ambito astrofisico. Per esempio: si crea in un computer una distribuzione di gas primordiale, e la si fa evolvere in base alla gravità. Quel che si osserva dopo la ripetizione di moltissimi calcoli, è qualcosa di simile ad una galassia a spirale? Ad una galassia ellittica? Qualsiasi sia la risposta, l’intero processo intellettuale consiste nel preparare un esperimento “numerico”, nel farlo arrivare fino alla fine, e nell’interpretare il suo risultato finale confrontandolo con altri dati o con le leggi della fisica note. Dal confronto di cosmo reale e cosmo simulato, capita che gli astronomi imparino cose nuove sull’Universo; nel prosieguo vedremo come, e quando questo capita.

Gli albori: l’Universo in cento particelle.

A partire dagli inizi degli anni ’70, alcuni centri di ricerca nel mondo acquisirono abbastanza potenza di calcolo per realizzare le prime pionieristiche ricerche di astrofisica numerica. Al confronto della potenza di calcolo di oggi, il paragone è impietoso: persino nel migliore centro di calcolo esistenti a quell’epoca i computer potevano effettuare appena qualche migliaia di operazioni al secondo, mentre un normale laptop da ufficio ne può effettuare almeno un miliardo a secondo, ovvero lavora un milione di volte più velocemente! A peggiorare la situazione, bisogna anche considerare che la grafica era veramente minimale, e l’interazione tra programmatore e programma era qualcosa di estremamente difficoltoso (per esempio, le istruzioni da dare ai programmi venivano letteralmente inseriti manualmente nelle unità di lettura, sotto forma di decine o centinaia di blocchetti di carta perforata da infilare dentro apposite fessure presenti nei primi, ingombratissimi antenati dei computer attuali). Tuttavia, tanto era ridotto il possibile margine di improvvisazione e di errore (visto che la lentezza del processo rendeva impossibile fare poco più di una manciata di tentativi al giorno) che gli astrofisici dovevano pensare in tutti i modi a come rendere i calcoli semplici il più possibile, lavorando di approssimazione in approssimazione.

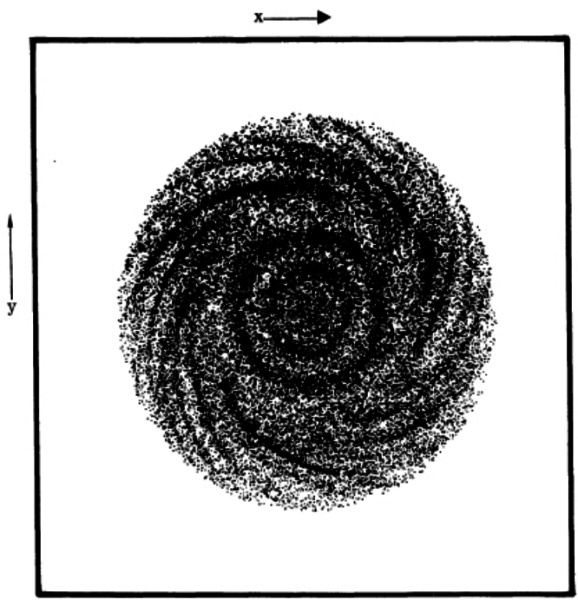

Anche grazie a queste ristrettezze, primi astrofisici computazionali si accorsero che per ottenere una buona rappresentazione di una galassia (solitamente composta da 100 miliardi di stelle) non era necessario alcuni decenni, fino a quando la tecnologia avesse davvero permesso di calcolare l’evoluzione di un sistema tanto mastodontico di oggetti: anche alcune migliaia potevano bastare per cominciare. Con questo approccio, le ogni singola particella 1 creata nel computer avrebbe rappresentato la massa non di una sola stella, ma di 100 milioni di stelle “incollate assieme”. Addirittura usando un numero di stelle inferiori a 10 000, già verso il 1969-70 fu possibile ottenere le prime realistiche simulazioni della formazione di galassie a disco solcate da una spirale (vedi immagine): non male se si pensa che una reale galassia è costituita in verità da una quantità almeno dieci milioni di volte maggior di stelle!

Simulazioni a particelle e simulazioni a griglia

La legge di gravitazione universale enunciata nel 1687 da Isacc Newton è una delle leggi più semplici della fisica (F=GM1 M2 /R2 , F è la forza di gravità, M1 e M2 sono le masse in gioco, R è la loro mutua distanza e G è la costante di gravitazione universale di Newton), ma anche una delle più “scorbutiche” da calcolare. Infatti ottenere l’evoluzione esatta di qualsiasi insieme con più di 3 corpi è impossibile, ed inoltre la forza di gravità non sparisce colla distanza (anche se si attenua di molto), e per questo motivo simulare l’evoluzione delle orbite di 100 stelle nello stesso spazio richiede il calcolo di ogni singola perturbazione che ciascuna stella esercita sulle altre. Questo tipo di problema può diventare troppo gravoso in termini di tempo di calcolo anche per i più sofisticati computer moderni. Gli anni ’80 hanno tuttavia portato alla invenzione di una nuova tecnica approssimata per il calcolo della forza di gravità in questi sistemi (detta tecnica “griglia-particella”), col risultato di rendere fattibili

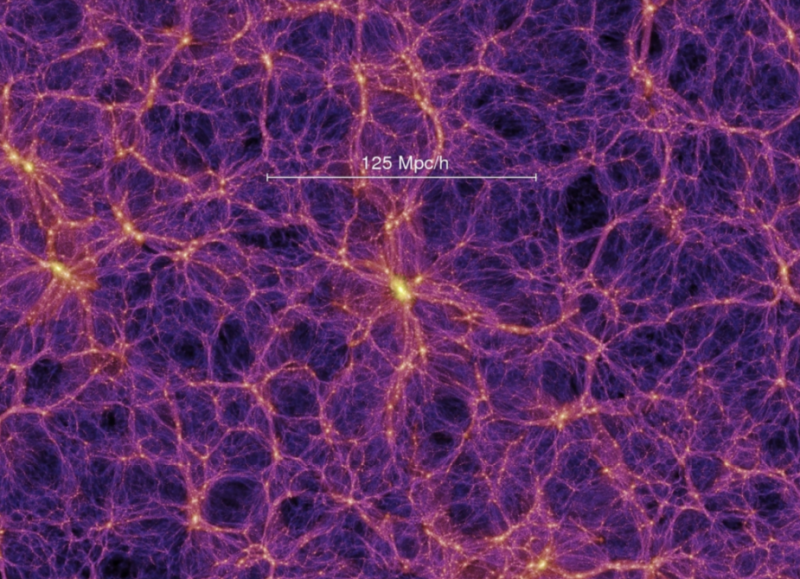

simulazioni anche con milioni o miliardi di stelle (attualmente il record è 2 miliardi di “stelle”, vedi immagine sotto).

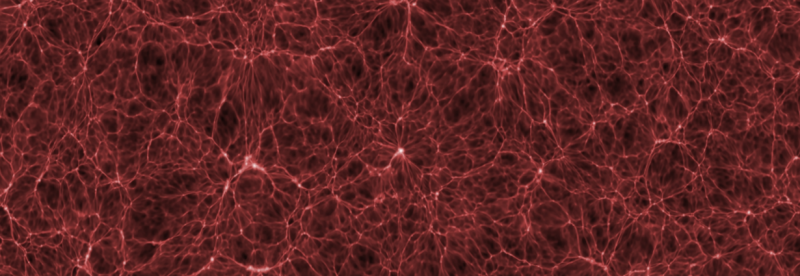

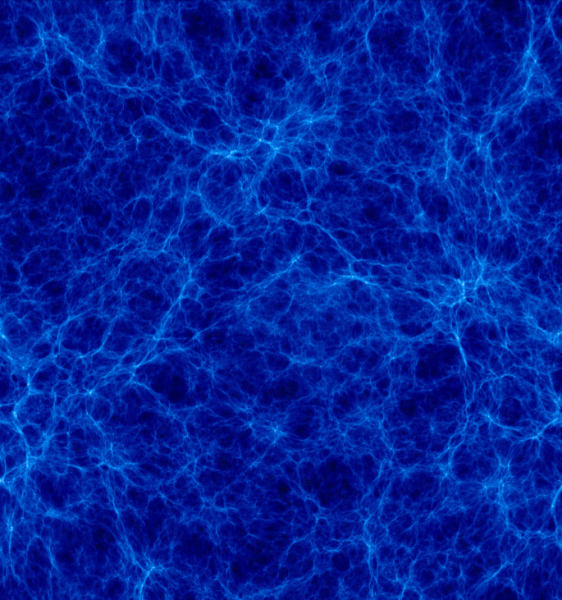

L’applicazione più spettacolare e proficua di questa nuova tecnica è stata quella di calcolare per la prima volta le proprietà su grande scala dell’Universo che ci circonda, utilizzando particelle di materia oscura (che, come sappiamo, è la componente di materia dominante nel Cosmo, circa 5 volte più abbondante della materia “ordinaria” che compone noi ed il mondo nel quale viviamo). Come per magia lunghissime catene e filamenti di “galassie” (all’epoca erano appena manciate di particelle) apparvero sugli schermi dei computer, separate da ampie porzioni di spazio vuoto ed talvolta intrecciate in densi “blob” di materia. Queste strutture non erano mai state ipotizzate degli astrofisici, che si sarebbero invece aspettati di trovare colossali “torte” o dischi di materiale nei quali le stelle e le galassie si formavano. Tuttavia esattamente negli stessi anni, le prime survey (cioè scansioni) al telescopio del cielo profondo mostravano dettagli molto simili a quelli prodotti dai computer, ovvero rivelavano che il Cosmo alla scala delle galassie ha una struttura filamentare riempita di materia oscura, galassie e gas rarefatto (questa evidenza è stata spettacolarmente confermata sia dalle survey più recenti, sia dalle migliaia di altre simulazioni cosmologiche). Se davvero un codice numerico in un computer poteva vedere qualcosa di più di un essere umano, in un problema di questo tipo, forse valeva davvero la pena di investire anche su questo metodo di ricerca! Tale successo decretò il “boom” delle simulazioni cosmologiche negli anni seguenti.

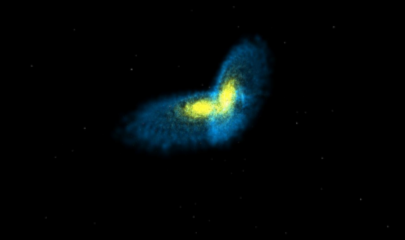

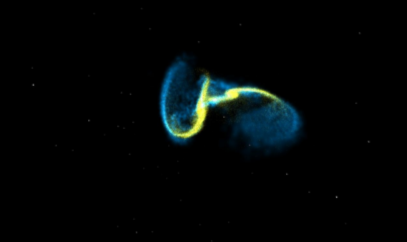

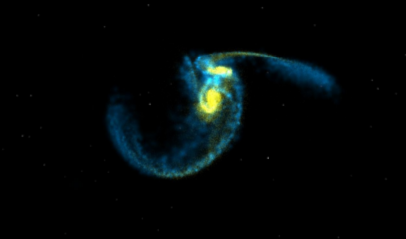

Simulazioni “piccole”….

Piccole simulazioni vengono quotidianamente realizzate in ogni università o centro di ricerca, come prima “esplorazione” di dati o teorie. Universi virtuali rappresentati da qualche centinaio di celle o di particelle (ovvero a bassa risoluzione) vengono fatti vivere per qualche decina o centinaia di ore, giusto il tempo di farsi una iniziale idea della possibilità o meno di indagare proficuamente un qualche fenomeno per mezzo delle simulazioni. Si può essere per esempio interessati ad indagare la dinamica della collisione tra due galassie a disco. Per cominciare a farsi un’idea di quanto catastrofico possa essere l’impatto, non è necessario simulare tutte le varie componenti di materia realmente presenti in una galassia (materia oscura, gas caldo, nubi molecolari, stelle), ma può per esempio bastare costruirsi un modellino fatto solo di materia oscura, e caratterizzato da un numero contenuto di particelle (qualche migliaio). Questo permette di simulare tantissime diverse configurazioni di impatto (per esempio con i due dischi paralleli, oppure messi perpendicolarmente tra di loro, eccetera). Gli standard attuali dei computer permettono addirittura di effettuare queste prove in tempo reale, e i lettori curiosi saranno contenti di poter trovare a questo indirizzo web: http://burro.cwru.edu/JavaLab/GalCrashWeb/ una applicazione Java interattiva che permette di simulare una varietà infinita di collisioni tra galassie (in bassa risoluzione). Una volta trovate le condizioni più interessanti da studiare, un simulatore può salvare sul suo computer le condizioni iniziali della simulazione, ed arricchirle di tutte le componenti mancanti; questo è possibile perché la materia oscura, essendo la componente dominante di questi sistemi, non modifica di molto la sua evoluzione se accoppiata anche a stelle o gas. Quindi una stessa collisione simulata tra galassie, con o senza stelle o gas, produrrà all’incirca le stesse morfologie finali. Tuttavia l’aggiunta di stelle e nubi di gas simulate può permettere di ottenere mappe virtuali di emissione a varie bande, da confrontare per esempio con immagini di Hubble di galassie reali. Uno dei primi spettacolari successi in questo campo è stato ottenuto da Mihos e Hernquist verso la fine degli anni ’90, i quali utilizzando simulazioni con materia oscura, gas e stelle (oltre 260 mila) hanno riprodotto in modo sorprendentemente fedele la morfologia di galassie interagenti fortemente perturbate come le “Antenne” (NGC 4038/4039 nella costellazione del Corvo), compresa loro “coda” di stelle e materiale espulso per centinaia di migliaia di anni luce nel vuoto cosmico in seguito alla collisione (vedi immagine sotto).

…e simulazioni “grandi”.

La costruzione di grandi centri di calcolo ha permesso agli scienziati di far girare i loro programmi non più su un solo computer, ma su centinaia e migliaia di computer che lavorano “in parallelo”. Nei sistemi di questo tipo, è possibile spezzettare uno stesso enorme calcolo in moltissimi diversi processori, che all’unisono risolvono pezzetti diversi dello stesso problema e si sincronizzano ciclicamente per assemblare l’intera simulazione. Se un singolo processore compila un programma in 10 minuti, dieci processori in parallelo ci impiegheranno un minuto soltanto, e centro processori appena 6 secondi. Decisamente un bel guadagno, per tutti quei complessi calcoli astrofisici che altrimenti impiegherebbero un tempo ben più lungo di una intera vita umana per arrivare ad un risultato!

In ambito italiano il centro di calcolo più potente è il CINECA di Casalecchio di Reno (vicino Bologna), che con i suoi 5376 processori è attualmente al 46mo posto tra i centri di calcolo più potenti del mondo. Molto di recente, la dimostrazione più spettacolare d iquesta capacità di far lavorare diversi computer in parallelo si è avuta con una grande simulazione fatta girare in simultanea su diversi computer separati…27 mila chilometri (la distanza Tokio-Amsterdam attraverso Oceano Atlantico, USA e Pacifico), in un avvincente esperimento di cosmologica numerica.

Ogni tanto un problema astrofisico particolarmente importante crea attorno a sé talmente tanto interesse, che nella comunità dei simulatori cresce l’esigenza di varare un progetto particolarmente corposo, in termini di risorse e di tempo calcolo, colla speranza di arrivare ad una soluzione soddisfacente. All’inizio di questo nuovo secolo, una delle domande fondamentali era: come nascono, e come evolvono le galassie nel cosmo? Come giustificare le loro diverse morfologie, e come collegare la loro evoluzione a quella dei buchi neri super-massicci nel frattempo scoperti dalle osservazioni, al centro di pressoché ogni nucleo galattico?

I migliori telescopi del mondo posso produrre una quantità preziosissima di dati dell’Universo vicino o profondo, ma senza la comprensione teorica possono restare un mucchio di immagini affascinanti; una teoria in grado di spiegare l’evoluzione e l’interazione di milioni di galassie in 13 miliardi di anni è qualcosa che nessun singolo cervello umano può fare in modo quantitativo.

Per cercare di venire a capo del problema, nel 2004-05 un consorzio di centri di ricerca internazionali (il “Virgo Consortium”) ha unito le forze per produrre una simulazione colossale per l’epoca, il Millennium Run (http://www.mpa- garching.mpg.de/galform/virgo/millennium/), che ha corso per 1,4 milioni di ore sui 2048 processori del centro di calcolo di Garaching (vicino a Monaco di Baviera). Il Millennium Run ha studiato un “cubo” di Universo di circa 2 miliardi di anni luce di lato, contenente almeno 20 milioni di galassie. La formazione, l’evoluzione e le proprietà chimiche e fisiche a tutte le scale delle galassie era il principale obiettivo d’indagine di questa impresa colossale, o per meglio dire è tutt’ora, perchè gli oltre 25 Terabyte di dati prodotti dalla simulazione sono tutt’oggi oggetto di studio. Data la quasi contemporaneità tra la sua realizzazione ed il completamento di due delle più importanti scansioni del cielo profondo con i telescopi ottici (la Sload Digital Sky Survey e la 2Degree Field Survey), la Millennium ha costituito un importantissimo banco di prova per testare la plausibilità di diversi modelli di formazione delle galassie, e della loro evoluzione morfologica.

In particolare, ha permesso di produrre previsioni quantitative del tasso di formazione di buchi neri supermassicci al centro di ogni galassia (fenomeno suggerito a partire dalla fine degli anni ’90 soprattutto dalle osservazioni di Hubble Space Telescope), e delle proprietà statistiche delle loro emissioni per un volume di Universo mai indagato prima di allora. C’è da dire che non tutte le previsioni discese dal Millennium Run si sono rivelate esatte (per esempio la distribuzione nel tempo di galassie ellittiche o a disco non sembra in accordo con le successive osservazioni ad alto redshift prodotte dalle survey di ultima generazione); tuttavia è stato proprio grazie a questo “esperimenti” numerico che si è iniziato a capire quali ulteriori ingredienti fisici – come la dettagliata interazione energetica tra i buchi neri, le loro regioni di accrescimento e la regioni stellari circostanti – fossero necessarie per meglio spiegare i dati reali. Con una sofisticata simulazione di questo tipo, la ricercatrice italiana Tiziana di Matteo e collaboratori hanno per esempio prodotto nel 2005 l’avvincente sequenza di una collisione tra galassie a spirale ciascuna delle quali contenente un buco nero supermassiccio, ottenendo delle previsioni quantitative di come il tasso di formazione stellare, l’accrescimento sul buco nero e la velocità delle stelle nella regione più interna alle due galassie venissero cambiate dall’impatto (vedi figura sottostante).

Altre simulazioni “colossali” nei tempi recenti sono state la “Hubble Volume Simulation” (prodotta da un consorzio di centri di ricerca in Europa, USA e Canada) il cui scopo è stato quello di scandagliare un volume di universo pari a quello accessibile alla più lunga esposizione dell’Hubble Space Telescope (circa 20 miliardi di anni luce di distanza di luminosità!) e la “Mare Nostrum Simulation” che ha usato il più grande centro di computazione presente in Europa (a Barcellona) per studiare l’evoluzione di grande volume di Universo per mezzo di 2 miliardi di “particelle”, in questo caso simulando nel dettaglio anche l’evoluzione della materia barionica e delle stelle.

Simulazioni in Italia.

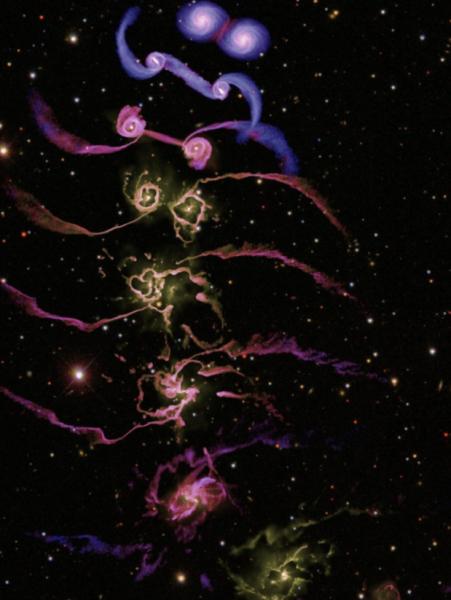

Molti istituti di ricerca italiani sono coinvolti in prima linea nella produzione di simulazioni cosmologiche. A Trieste (presso l’Osservatorio Astornomico, l’Università e la SISSA si studiano in particolare i meccanismi coi quali il gas rarefatto tra le galassie viene riscaldato e ionizzato dalla luce di stelle e dei nuclei galattici attivi (meccanismo detto di “re- ionizzazione”). Anche la formazione e l’evoluzione degli ammassi di galassie costituisce un tema molto seguito (vedianche riquadro “Un astrofisico numerico italiano di spicco”). Presso il Dipartimento di Astronomia si calcolano le proprietà della materia oscura alle scale più grandi, e si prova anche a spiegare come alcuni tipi morfologici di galassie si riescano a formare in ambienti cosmici poco densi di materiale primordiale. Al il Dipartimento di Fisica e all’Osservatorio di Torino, recentemente si è sviluppato un approccio innovativo per seguire la ricca catena di reazioni che forma le stelle e fa interagire le supernove in esplosione col mezzo interstellare, nel contesto delle simulazioni cosmologiche. Anche a Bologna (Dipartimento di Astronomia, Osservatorio ed Istituto di Radio Astronomia) le simulazioni cosmologiche sono un utile strumento di indagine del cosmo. Chi vi scrive ed il suo gruppo di ricerca, in collaborazione con il CINECA, sta conducendo da qualche anno nuove simulazioni del Universo a grande scala, indagando i meccanismi che si crede stiano alla base dell’accelerazione di particelle relativistiche negli ammassi di galassie e della loro conseguente emissione di energia alle bande Radio (e Gamma). Crediamo infatti che, quando un ammasso si forma dalla collisione di masse più piccole, vortici ed onde d’urto vengano generate e si propagano nel plasma caldissimo tra galassia e galassia, e cedano una parte significativa della loro energia a protoni ed elettroni del plasma, fino a farli sfrecciare alla velocità della luce. Vortici e shock, purtroppo, sono stati osservati molto di rado negli ammassi reali (e mai nelle regioni più esterne), perché i telescopi attualmente in funzione non hanno sufficiente sensibilità. Tuttavia, questi fenomeni sono comunemente “osservati” nelle nostre simulazioni, e sembrano giocare un ruolo fondamentale. Per questo motivo nell’attesa dei dati chiarificatori che la imminente generazione di radio interferometri produrrà (come LOFAR, nel cuore dell’Olanda, e lo SKA in Sud Africa ed in Australia), gruppi di ricerca come il nostro (vedi immagine sotto) hanno concentrato le loro energie nel descrivere nel modo più dettagliato possibile l’evoluzione di onde d’urto e vortici negli ammassi di galassie. L’analisi di questi dati è appena iniziata, ma da ogni ammasso è già emersa una varietà incredibile di vortici, mulinelli e moti caotici, che sarebbe splendido poter vedere un giorno per davvero immortalati da un telescopio reale. Tuttavia, nell’attesa di quel giorno, useremo questi dati per produrre previsioni di emissioni radio dagli ammassi più vicini, da confrontare già ora con le osservazioni esistenti (prodotte per esempio dal Very Large Array, il grande sistema di parabole nel deserto del New Mexico, negli Stati Uniti).

simulazioni ad altissima risoluzione realizzate presso il CINECA (Vazza et al.2010;

http://www.ira.inaf.it/~vazza/key_p.html). I colori mostrano la distribuzione del plasma

“freddo” (<107 K, in nero) e “caldo” (>108 K, in bianco) per una regione di 8 milioni di

anni luce di lato, centrata nel centro dell’ammasso. L’immensa gamma di moti caotici

prodotta dalla simulazione, deve essere ancora confermata dalle osservazioni ai telescopi

X. Il calcolo ha impiegato in totale 800 mila ore, usando 512 processori.

Il Futuro

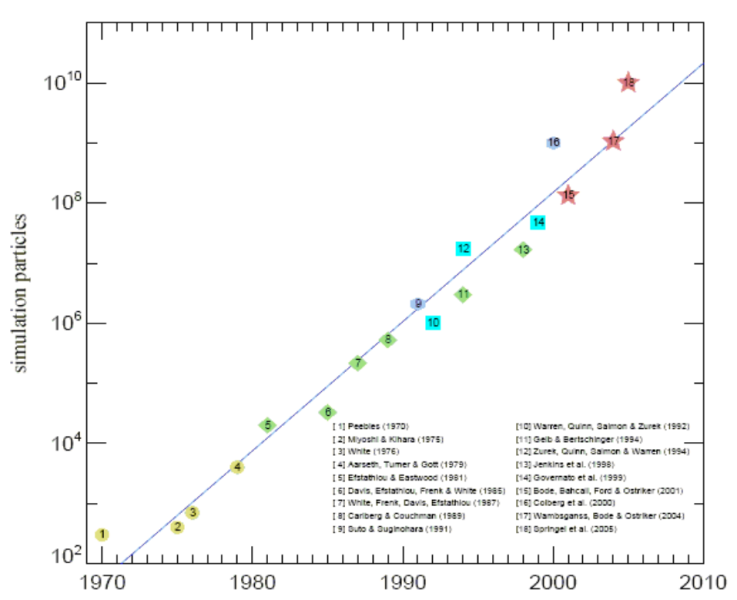

Cosa ci potrebbero riservare le simulazioni del futuro? Alcune previsioni sono abbastanza immediate. Come moltissime altre applicazione tecnologiche avanzate, la mole di dati accessibili alle simulazioni cosmologiche dipende dall’avanzamento della potenza dei computer disponibili nel mondo. Il progresso della potenza di calcolo segue, ininterrottamente da almeno quarant’anni un trend regolarissimo, grazie al quale ogni dieci anni diventa fattibile un calcolo cento volte più grande (in termini di memoria e tempo calcolo) rispetto a dieci anni prima. La rappresentazione grafica di questo andamento è mostrata nella figura sottostante). Questo significa, per esempio, che se all’inizio del 2000 era possibile calcolare l’evoluzione di cento milioni di particelle in una simulazioni, attualmente se ne possono considerare 10 miliardi, e così via. Questo implica, per esempio, che nel giro di dieci o vent’anni anche una simulazione grande come il Millennium Run potrà riprodurre, in linea di principio, oggetti come la Via Lattea o M31 descrivendole con tante particelle quante sono le stelle realmente presenti in questi sistemi (almeno cento miliardi)!

Non è tuttavia scontato che, quando ci sarà la potenza di calcolo necessaria, conosceremo davvero anche tutta la fisica necessaria per descrivere una galassia in modo realistico! E’ infatti scontato ricordare che i computer da soli sanno soltanto eseguire delle istruzioni che un essere umano, che conosce alcune leggi della fisica in questo caso, ha impartito loro. Al momento, nessun astronomo conosce veramente la complessa catena di eventi che, dopo qualche centinaia di anni dopo il Big Bang, ha cominciato a raggruppare il plasma cosmico primordiale facendone prima stelle, poi galassie ed infine ammassi di galassie: questa catena di eventi, con tutte le sue variabili nascoste ancora da scoprire, è ancora in parte sconosciuta. Lo è tuttavia infinitamente di meno rispetto a un centinaio di anni fa, parzialmente anche grazie all’oscuro lavorio di stringe di bytes nei computer di mezzo mondo, che incessantemente cercano di dare una forma intellegibile a tutte le immagini, spesso prodigiose e commoventi, che l’astronomia osservativa produce di continuo.

(rielaborato da “L’Universo nei Computer” di F.Vazza, Le Stelle 01/2011)

Versione PDF qui

Links

http://www.youtube.com/user/cosmofra collezione di simulazioni dello scrivente!

http://www.mpa-garching.mpg.de/galform/virgo/millennium/

http://astro.ft.uam.es/marenostrum/index.html mare nosrum

http://www.ifa.hawaii.edu/faculty/barnes/transform.html barnes

http://irfu.cea.fr/Projets/Site_ramses/Movies.html ramses

http://astro-staff.uibk.ac.at/~hydroskiteam/index.htm inssbruck

http://www.mpa-garching.mpg.de/Virgo/hubble.html#intro hubble volume simulations

http://burro.cwru.edu/JavaLab/GalCrashWeb/ applet Java per simulare inerattivamente la collisione tra galassie

http://data.cineca.it/